Роботы-убийцы: как научить их отличать своих от чужих?

Фирма-производитель оружия в городе Тэджон в Южной Корее разработала и построила пулеметную башню, способную засечь, сопроводить и поразить цель, теоретически — без участия человека. У корреспондента BBC Future возник закономерный вопрос, кто в таком случае обучит солдат-роботов правилам ведения боя?

На зеленом холме, возвышающемся над Тэджоном, городом в центральной части Южной Кореи, установлена башенка с пулеметом, визир которой медленно скользит вдоль линии горизонта. Башенка имеет размеры крупной собаки, она довольно массивная, выкрашена в белый цвет и идеально чистая. Лента с патронами 50-го калибра (12,7 мм), способными остановить несущийся на полной скорости грузовик, перекинута через левое «плечо» башни, передает ВВС.

Сетевой кабель от основания башни змеится по аккуратно подстриженной траве и скрывается в маленькой беседке с парусиновым навесом. В послеобеденную корейскую жару вас вряд ли кто осудит, если вы рассчитываете найти здесь блюдо с огуречными сэндвичами и чайник с чаем.

Но вместо сэндвичей и чая на раскладном столе покоится компьютер, к разъему на задней панели которого и подсоединен кабель. На монитор выведены цветные изображения, запитанные с нескольких камер. На одном из полей, на которые разделен монитор, 180-градусная развертка горизонта перед нами. На другом поле представлен вид со спутника, который больше всего напоминает участок карты Google.

Красный конус, наложенный поверх изображения, обозначает дальность стрельбы башенного пулемета. Он покрывает окрестный пейзаж на глубину в четыре километра. Этой дальности хватит, чтобы держать под прицелом внутренние районы города с огневой точки, расположенной на удобной господствующей высоте.

Рядом с клавиатурой находится сложный джойстик, такого типа, который могли бы использовать энтузиасты, управляющие виртуальным самолетом на компьютерном авиационном тренажере.

Клейкой лентой к столу прикреплен ламинированный лист бумаги, на котором указаны функции каждой из многочисленных кнопок. Одна обозначает прицел. Другая измеряет расстояние от пулемета до цели. Еще одна подает патроны в патронник. Нажмите на спуск, и пулемет откроет огонь.

Стайка инженеров, окруживших стол, вздрагивает, когда из установленного на треноге массивного громкоговорителя внезапно раздается лающий голос, выкрикивающий предупреждение.

На мониторе компьютера мигает квадратик прицела и захватывает изображение некоего транспортного средства, которое перемещается в видоискателе камеры. Ствол пулемета, как зрительный образ из футуристической военной игры-стрелялки Call of Duty, перемещается синхронно с красным квадратом, движущимся по экрану.

Обладатель лающего голоса, который должен сопровождать пулеметную башню во всех ее эволюциях, известен как акустический робот-сигнальщик. Его голос слышен на расстоянии в три километра. Звук с невероятной точностью доходит до потенциальной цели и предупреждает ее, прежде чем по ней будет открыт огонь.

Автоматическая пулеметная башня Super aEgis II, южнокорейский бестселлер, способна поражать цель на расстоянии в 4 км

Предупреждение должно предварять любую стрельбу, таково требование международного законодательства, говорит мне один из инженеров, одетый в лабораторную робу. «Поворачивайте! — выкрикивает голос по-корейски стремительной скороговоркой. — Поворачивайте, или мы будем стрелять!»

Обратите внимание на местоимение «мы». Это важно. Автоматическая пулеметная башня Super aEgis II, южнокорейский бестселлер, не начнет стрелять, не получив прежде команды «огонь!» от человека.

Оператор должен сначала ввести пароль в компьютерную систему пулеметной башни, чтобы разблокировать функцию стрельбы. Затем команду, разрешающую открыть огонь необходимо ввести вручную.

«Поначалу все задумывалось по-другому», — говорит Чон Сок Пак, ведущий инженер-исследователь компании DoDAAM, производящей башню-робота. Пак работает в подразделении компании, занимающемся роботизированными системами разведки. Оно расположено в Юсон-гу, высокотехнологичном районе Тэджона (который считается научно-технической столицей Южной Кореи). В штате подразделения 150 человек. Большинство из них, как и Пак, — инженеры.

«Наша исходная разработка была системой автоматического стрельбы, — объясняет он. — Однако заказчики просили внедрить элементы защиты. С технологической точки зрения, это не стало для нас проблемой. Однако все опасались, что пулемет может совершить ошибку».

Робот-пулемет Super aEgis II, который впервые был представлен в 2010 году, относится к новой разновидности автоматизированных систем оружия, способных обнаруживать, отслеживать и уничтожать движущиеся цели на большой дистанции. Теоретически — без вмешательства человека.

В южнокорейском Тэджоне — немало фирм, разрабатывающих военные роботы

Машина оказалась популярной и прибыльной. По утверждению компании DoDAAM, с момента запуска продано уже более 30 таких установок, каждая из которых является составной частью интегрированных оборонительных систем стоимостью свыше 40 млн долларов.

Башни стоят на боевом дежурстве на многих объектах, расположенных на Ближнем Восток, в том числе на трех авиабазах в Объединенных Арабских Эмиратах (Аль-Дафра, Аль-Сафран и Аль-Минад). Они охраняют королевский дворец в Абу-Даби, арсенал в Катаре, а также множество других неназванных аэропортов, электростанций, трубопроводов и военных авиабаз в других районах мира.

В течение последних 15 лет наблюдается скоординированная разработка подобных автоматизированных систем вооружения и беспилотных аппаратов. Американские военные используют похожих полуавтономных роботов для обезвреживания взрывных устройств и инструментальной разведки.

В 2000 году Конгресс США принял решение о том, что треть сухопутных боевых машин и самолетов, предназначенных для ударов на большую глубину, должны быть заменены роботами.

Шесть лет спустя сотни тактических мобильных роботов PackBot применялись в Ираке и Афганистане. Они открывали двери, ведущие в дома, во время боевых действий в городах, прокладывали оптоволоконные кабели, обезвреживали взрывные устройства и выполняли другие смертельно опасные функции, которые в противном случае легли бы на плечи людей.

Самоограничения

Еще в 2005 году газета New York Times написала, что Пентагон планирует заменить солдат автономными роботами. Легко понять, почему. Применение роботов сокращает потребность в людях в бою, что дает возможность сберечь жизни солдат, моряков и летчиков.

Какой родитель пошлет своего ребенка в зону боевых действий, если вместо него солдатскую работу способен выполнить автомат? Но хотя такие устройства, как Super aEgis II, способные убивать автономно, существуют уже более десятилетия, широкой публике пока не известны случаи активного широкого применения полностью автономных, оснащенных оружием роботов в реальных боевых операциях.

Сформулированное писателем-фантастом Айзеком Азимовым «Первое правило робототехники» (в рассказе «Хоровод», 1942 год), гласящее «робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред», похоже, скоро будет нарушено.

Призыв правозащитной организации Human Rights Watch ввести всеобъемлющий запрет на «разработку, производство и применение полностью автономных вооружений» представляется до абсурда нереалистичным. Такие машины уже существуют, продаются на свободном рынке, хотя и с «навязанными самим себе ограничениями», как выражается инженер Пак из компании DoDAAM.

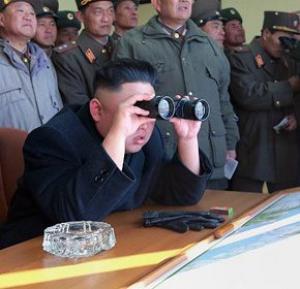

На границе Южной Кореи и КНДР напряжение сохраняется аж с 1950-х годов

«Когда мы начинали этот бизнес, мы увидели все открывающиеся возможности», — говорит Ён Чен Сон, управляющий директор DoDAAM по стратегическому планированию. Мы сидим с ним прохладной комнате для совещаний после демонстрации возможностей робота-пулемета.

«За автоматизированным оружием будущее. Мы оказались правы. Эволюция шла очень быстро. Мы уже отошли от дистанционно управляемых боевых устройств и движемся к созданию умных приборов, способных самостоятельно принимать решения», — рассказывает он.

Южная Корея превратилась в лидера в этой области военной робототехники, поскольку страна имеет общую границу с заклятым врагом, утверждает генеральный директор DoDAAM Мён Квон Чен (осанистый мужчина, совершающий обходы коридоров своего предприятия в сопровождении красавца-хаски с голубыми глазами, которого, как меня предупредили, не следует трогать ни при каких обстоятельствах).

«Нужда – мать изобретательности, — говорит он. – Мы живем в уникальных условиях. У нас под боком находится могучий противник, от которого не избавиться. Из-за этой постоянной угрозы у нас в стране возникла традиция крепить военную мощь и разрабатывать инновационные вспомогательные технологии. Наше оружие никогда не спит, в отличие от людей, которые не могут обходиться без сна. Таким образом, наши технологии заполняют бреши в человеческих возможностях».

В демилитаризованной зоне или ДМЗ, полосе ничейной земли, отделяющей демократическую Южную Корею от живущей под властью диктатуры Северной Кореи, фирма DoDAAM и ее конкурент Samsung, также разработавший (ныне не действующую) автоматизированную пулеметную башню, провели несколько испытаний модели Super aEgis II.

ДМЗ – идеальный полигон для подобного оружия. Зона разделяет две Кореи со времени окончания боев в 1953 году. Поскольку стороны не подписали соглашение о прекращении огня, ДМЗ остается необитаемой буферной зоной, тщательно охраняемой тысячами солдат с обеих сторон.

Дело не только в том, что автоматизированная пулеметная башня никогда не спит и способна видеть в темноте благодаря тепловизионной камере. Если она ориентирована в верном направлении, можно не сомневаться, что любая движущаяся мишень, которая может попасть в поле ее зрения, обязательно окажется противником.

Впрочем, ситуация усложняется, когда машина оказывается в такой местности, где могут передвигаться свои и чужие. В настоящее время оружие не способно отличать одних от других.

Автоматической пулеметной башне не будет нужен человек — она на дежурстве круглые сутки

Ён Чен Сон сидит за широким столом в окружении пяти молодых инженеров, большинство из которых получили образование в колледжах Лиги плюща в США, прежде чем вернуться на работу в приносящей устойчивую прибыль военной промышленности Южной Кореи.

«Следующий шаг для нас – разработка таких программ, которые смогут отличать своих от чужих и гражданских от военных, — объясняет он. – Пока еще людям самим приходится определять, является цель противником или нет».

Чон Сок Пак и другие инженеры утверждают, что уже близки к тому, чтобы устранить необходимость человеческого вмешательства. Способность пулеметной башни Super aEgis II обнаруживать потенциальные цели в заданном районе доведена до совершенства. (Оператор может даже установить виртуальный периметр, в пределах которого башня будет выбирать только движущиеся цели.)

Кроме того, благодаря многочисленным камерам, как говорит Пак, программа, заложенная в башню, способна определить, не прячет ли потенциальная мишень взрывчатку под одеждой. «В течения ближайшего десятилетия мы сможем, я думаю, с помощью компьютерных технологий определять тип противника, исходя из одетой на нем формы», — говорит он.

Как только оружие начнет отличать свои войска от противника и автоматически открывать огонь по последнему, останется один маленький шаг до полной автоматизации. И в тот момент, когда оружие научится решать, кого и когда убивать, научная фантастика в духе «Робота-полицейского» станет фактом реальной жизни.

Немецкий философ Томас Метцингер утверждал, что перспектива увеличения объема страдания в мире столь ужасна с моральной точки зрения, что мы просто обязаны немедленно прекратить создавать роботов, наделенных искусственным разумом.

Однако финансовые выгоды для компаний, которые создают эти машины, настолько высоки, что мольбам Метцингера уготована участь гласа вопиющего в пустыне.

Роботы не идут. Они уже здесь. Вопрос лишь в том, чему мы их научим.

Нравственный выбор

«Дилемма вагонетки», которую английский философ Филиппа Фут впервые сформулировала в 1967 году, известна любому студенту, слушающему курс этики. Фут предложила вообразить следующий сценарий.

Тяжелая неуправляемая вагонетка несется по рельсам, приближаясь к стрелке. Прямо по курсу вагонетки оказываются пять человек. Они связаны и не могут пошевелиться. Вы можете перевести стрелку и направить вагонетку на другой путь. Но и там находится один беспомощный человек. Вагонетка может убить пять человек или одного, и вам предлагается сделать моральный выбор.

Как поступите вы, оператор, он же стрелочник? Поиск решения этических головоломок в скором времени станут вести не люди, а машины. Автомобилю без водителя придется решать, таранить ли машину, едущую впереди, и наносить увечья ее седокам, или же вылететь на обочину, рискуя здоровьем и жизнью собственных пассажиров.

У военных роботов на поле боя должна быть своя этика — но можно ли на них перенести этику человека?

Проект по созданию беспилотного автомобиля Google в определенной степени был вызван к жизни собственным жизненным опытом конструктора Себастьяна Труна, потерявшего близкого человека в автомобильной катастрофе. Трун, профессор Стэнфордского университета и специалист по искусственному интеллекту, пришел к убеждению, что создание беспилотных автомобилей, спасающих жизни людей, является для него моральным императивом.

Точно так же полностью автономная версия беспилотного летательного аппарата Predator может столкнуться с необходимостью самостоятельно принимать решение — стрелять или нет по дому, в котором укрываются как солдаты противника, так и гражданские лица.

Как вы, будучи инженером-программистом, будете конструировать свод правил, которым предстоит следовать беспилотным устройствам в подобных ситуациях? Возможно ли запрограммировать устройство таким образом, чтобы оно думало само за себя?

Многие идут по пути наименьшего сопротивления. Они стараются обходить такие вопросы, просто закладывая в программу машины, угрожающей жизни людей, возможность вмешательства человека в процесс принятия решения.

Это – одна из причин, приведших к запрету противопехотных мин Оттавским договором 1997 года. Противопехотные мины, если подходить к ним с самой примитивной точки зрения из всех доступных воображению, представляют собой автономные боевые средства, которые взрываются под каждым, кто на них наступает.

В этом контексте возможность человеческого вмешательства, безусловно, оправданна. Например, представляется само собой разумеющимся, что пилоты должны иметь полный контроль над системой автоматического пилотирования самолетов. Однако катастрофа самолета авиакомпании Germanwings в марте 2015 года, когда второй пилот Андреас Любиц умышленно направил авиалайнер A-320 в горный склон во Французских Альпах и убил 150 человек, находившихся на борту, серьезно усложнила дело.

Возможно, ни один пилот не должен иметь возможности вмешиваться в работу компьютера автопилота, по крайней мере, в тех случаях, когда человек может заставить самолет столкнуться с горой?

Если пилот может намеренно совершить крушение авиалайнера, значит ли это, что управление самолетами надо передать исключительно в руки роботов?

«Существуют многообразные подходы к попыткам создания машин, наделенных этическими представлениями, так же, как и множество подводных камней, — объясняет Гэри Маркус, специалист по проблемам философии познания и искусственного интеллекта в Нью-Йоркском университете, он же глава и создатель Geometric Intelligence. – Мы можем попытаться запрограммировать все заранее, однако это нетривиальная задача. Как, например, вы будете программировать «справедливость» или «вред»? Есть и другая сторона проблемы, помимо двусмысленных определений. Так, любой свод правил, устанавливаемый для автоматизированного солдата, неизбежно окажется либо слишком абстрактным, чтобы облечь его в компьютерную программу, либо слишком конкретным, чтобы охватывать все возможные ситуации».

Кое-кто полагает, что ответ заключается в том, чтобы попытаться воспроизвести то, как люди создают этические взаимосвязи, и научиться отражать различные моральные правила, пытаясь понять, какие из них соответствуют друг другу.

«Мы интуитивно ощущаем, что может оказаться этически приемлемым, наблюдая за тем, как ведут себя другие люди и как они реагируют на те или иные ситуации», — говорит Колин Аллен, профессор когнитивистики и философии науки в Университете штата Индиана, соавтор книги «Моральные машины: Как научить роботов отличать хорошее от плохого».

«Иными словами, мы учимся у других людей понимать, что приемлемо, а что – нет. Но существует опасность, что мы усвоим дурные манеры поведения, столкнувшись с неправильными примерами. Таким образом, машины либо должны обладать теми же способностями к обучению, либо придется жестко ограничить сферы их применения, фигурально выражаясь, прикрутить их болтами к заводскому полу».

Чон Сок Пак из компании DoDAAM предлагает, как представляется, разумный компромисс. «Когда мы создадим пулеметную башню, способную совершенно автономно принимать самостоятельные решения, мы добьемся того, чтобы искусственный интеллект придерживался положений соответствующего армейского устава. Мы будем придерживаться уставных положений и внедрять правила ведения боевых действий в нашу систему».

Замороженные ценности

Колин Аллен считает этот план далеко не безупречным. «Google признает, что одна из самых сложных проблем для их программистов состоит в том, чтобы задать манеру поведения беспилотного автомобиля под знаком «Стоп» на равнозначном перекрестке, — объясняет он. – При таком сценарии все дело заключается в том, чтобы быть на одной волне с местными нормами, а не просто руководствоваться правилами дорожного движения, которые мало кто из людей выполняет в точности».

Надо ли сомневаться в том, что в хаосе, царящем на поле боя, робот должен уметь мыслить самостоятельно? Точно так же существует опасность, что мы «заморозим» наши ценности, как военные, так и гражданские, в машинном «железе».

«Только представьте себе, что отцы-основатели США вдруг решили бы заморозить навечно свои ценности, которые разрешали рабство, ограничивали прав женщин и т.п., — говорит Гэри Маркус. – В конченом итоге, мы, скорее всего, хотели бы получить машину, обладающую хорошей основой для самообучения, и, вероятно, превосходящую наши возможности выносить моральные суждения».

Такие компании, как DoDAAM, продолжают брать все новые рубежи в своей области — быстрее, чем человечество успевает найти адекватные ответы на те вопросы, которые ставит их работа

С точки зрения Андерса Сэндберга, старшего научного сотрудника из Института будущего человечества в Школе Мартина в Оксфорде, возможные будущие блага, проистекающие из наделения машин способностью конструировать собственные этические системы, сопряжены с изрядными рисками.

«По-настоящему самообучающаяся система может воспринять различные ценности и теории допустимых и уместных действий, и если бы она была способна оценивать себя со стороны, она стала бы настоящим моральным агентом в философском смысле этого понятия, — говорит он. – Беда в том, что она может воспринять кажущиеся безумными или чуждыми ценности, если будет отталкиваться от общепринятых человеческих взглядов».

Время, отпущенное для решения этих вопросов, понемногу истекает. Такие компании, как DoDAAM, продолжают брать все новые рубежи в своей области, причем делают это быстрее, чем наш биологический вид успевает найти адекватные ответы на те вопросы, которые ставят достижения в их работе.

«Сейчас мы должны инвестировать в то, чтобы разобраться, как регулировать компьютерные программы и как гарантированно добиваться того, чтобы программы делали именно то, чего мы от них хотим, — настаивает Маркус. – Нам также следует инвестировать в поиск способов внедрения в машины способности выносить этические суждения. Ни одна из этих задач не является легкой, и все они, весьма вероятно, приобретут критическое значение в предстоящие десятилетия».

Аллен, однако, верит, что время еще есть. «У нас есть возможность продумать все вероятные последствия и решения, пока технологии все еще находятся на стадии разработки, поскольку так будет не всегда», — говорит он.

И продолжает: «Я бы предложил создать комиссии из представителей бизнеса, правительства и граждан, наделенные полномочиями оценивать и отслеживать ввод в эксплуатацию машин, способных функционировать под ограниченным контролем со стороны людей — или без прямого участия человека — в общественных пространствах, таких как автомобильные дороги или воздушные маршруты».

Сэндберг согласен с этим, хотя он думает, что мы еще довольно далеки от того, чтобы иметь работающие решения, которые можно было бы интегрировать в систему регулирования.

Если военные машины научатся думать на поле боя, означает ли это, что человеку больше не придется проливать кровь на войне?

«Нужно срочно провести дополнительные исследования, — говорит он. — Серьезные изыскания в области машинной этики и безопасности искусственного интеллекта – это абсолютно новая область. На нас сваливаются все новые сюрпризы: это и нестабильность средств для создания «этических» машин, и глубокие философские вопросы, вырастающие из, казалось бы, простых инженерных проблем».

Сэндберг убежден, что ключ к решению лежит в междисциплинарных трудах философов, инженеров, психологов и даже экономистов. «Одной теории недостаточно, — считает он. – Мы должны работать в связке с людьми, которые конструируют и эксплуатируют такие системы».

Вернемся на завод компании DoDAAM в Тэджоне. У работающих здесь инженеров нет четких ответов на вопросы, которые так настойчиво ставит их работа. «Человеческая жизнь важнее всего, поэтому мы и применяем в нашей пулеметной башне средства обеспечения безопасности», — говорит Ён Чен Сон.

Однако для Пака и других инженеров из его подразделения это временное положение дел. Их цель заключается в том, чтобы сделать их детище «умнее» путем «повышения автоматической функциональности пулемета», внедрения системы «распознания целей» и создания «полностью взаимосвязанных систем», когда башни будут связаны в одну интегрированную сеть друг с другом, что позволит им покрывать более обширные секторы.

Независимо от того, что станет возможным в будущем, автоматизированные пулеметы способны засекать, сопровождать, предупреждать и уничтожать человеческие цели, не нуждаясь в том человеческом взаимодействии, которое уже существует в нашем мире.

Без четко прописанных международных правовых норм единственное, что может удержать производителей от продажи таких машин, — это, очевидно, совесть. Причем не инженера или робота, а клиента.

«Если к нам придет некто и скажет, что хочет приобрести пулеметную башню без существующих ограничителей по части безопасности, мы конечно, постараемся его отговорить, указав на потенциальные угрозы, — говорит Пак. – Но в конечно итоге решение принимает покупатель, а мы выполняем заказ с учетом его пожеланий».

Будь в курсе всех событий! Подписывайся на наши новости: Vk.com; Twitter; Facebook

Запись Роботы-убийцы: как научить их отличать своих от чужих? впервые появилась Новостной интернет-портал IPnews.

Продолжение здесь: IPnews

Человечество вплотную приблизилось к созданию

Гонка вооружений дошла до того, что в 40 странах мира стали разрабатывать роботов, способных воевать без человеческогоКНДР отрабатывает ядерные удары по Южной Корее

КНДР провела учения, которые моделируют детонацию ядерных боеголовок, установленных на ракеты, которые направлены наВ Южной Корее карантин: вирус МЕРС «косит» всех

Только за сутки там заболели 23 человека, общее количество больных — приближается к сотне. Из-за вспышки вируса МЕРС вВ США загадочные сотовые башни перехватывают звонки

Загадочные фальшивые сотовые башни перехватывают телефонные звонки по всем Соединённым штатам.Нет комментариев.

Информация

Посетители, находящиеся в группе Гости, не могут оставлять комментарии к данной публикации.